21/6/2012

Odzyskiwanie utraconych danych klientów chmury e24cloud.com zostało już zakończone. Teraz przyszedł czas na dokładną analizę i naukę na błędach. Dotarliśmy do PDF-a, w którym pracownicy serwerowni obszernie opisują jak krok po kroku starali się opanowywać sytuację i co dokładnie działo się w czasie awarii.

Odzyskano wszystkie dane klientów

Najważniejsza informacja dla klientów e24cloud.com jest taka, że po 8 dniach wytężonych prac udało się odzyskać 100% danych klientów, którzy nie wykonywali backupów swoich maszyn. Odzyskano dane z uszkodzonych macierzy oraz dane z cache’a.

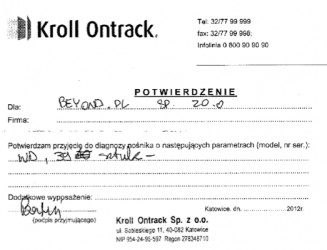

Z raportu dowiemy się, że firma Kroll Ontrack, która początkowo była chętna do pomocy, zmieniła zdanie i opóźniała proces odzyskiwania danych. Choć pracownicy e24cloud.com dowieźli do Ontracka dyski:

…szybko podjęli decyzję o przekazaniu prac innej firmie, która również zaoferowała pomoc w odzyskaniu danych. Firmą tą było MyData.pl — to właśnie jej pracownicy wraz z administratorami e24cloud.com musieli opracować autorskie narzędzia do rekonstrukcji uszkodzonego Raida 60 (komercyjnie narzędzia do rekonstrukcji zawierały błędy uniemożliwiające poprawne odzyskanie danych).

Koniec końców, odzyskano 100% danych! Z ciekawostek, prędkość odzyskiwania to 12GB/min. Po wszystkie szczegóły zapraszamy do pełnej wersji raportu z case-study.

Weź udział z kolegami w jednym z naszych 8 cyberwykładów. Wiedzę podajemy z humorem i w przystępny dla każdego pracownika sposób. Zdalnie lub u Ciebie w firmie. Kliknij tu i zobacz opisy wykładów!

Weź udział z kolegami w jednym z naszych 8 cyberwykładów. Wiedzę podajemy z humorem i w przystępny dla każdego pracownika sposób. Zdalnie lub u Ciebie w firmie. Kliknij tu i zobacz opisy wykładów! Każdy powinien zobaczyć te webinary! Praktyczna wiedza i zrozumiały język. 6 topowych tematów — kliknij tutaj i zobacz szczegółowe opisy oraz darmowy webinar.

Każdy powinien zobaczyć te webinary! Praktyczna wiedza i zrozumiały język. 6 topowych tematów — kliknij tutaj i zobacz szczegółowe opisy oraz darmowy webinar.

Mówiąc dużym skrótem, szacun :)

No to teraz mają komercyjne narzędzie bijące konkurencję na głowę, czyż nie?

tak i chwała im za to. Kolejny raz polska myśl techniczna bije zachodnia, to już norma.

kto z kim o co konkuruje i walnąć cię w głowę?

Mają, będzie przydatne jak e24 po raz kolejny się wysypie ;)

no cóz mi pozostaje pogratulować profesjonalizmu chociaż zdziwiłem się odrobinę tymi “sprawdzonymi metodami” czyżby panowie pracujący tam byli osobami starej daty ? ,

no cóz tak czy siak cloud24 już wie do kogo w przyszłości się zgłaszać a Mydata.pl zyskało reklame

a Kroll Ontrack antyreklamę ;]

Tak sie własnie wspina na szczyt

“inoformacja” – literówka

PS

Dobra reklama dla tej firmy ;-)

Cenowo tez bija ontracka na glowe :)

szacunek naprawde i juz wiem z jakiej firmy do odzyskiwania danych nastepnym razem bedziemy kozystac :)

i tak oto pracowitosc konczy sie darmowa reklama w branzowym serwisie ;>

Ciekawe dlaczego zrezygnowali z Kroll Ontrack, czyżby firma nie była w stanie poradzić sobie z stworzeniem “autorskiego narzędzia” ?

Z tą firmą tak jest. Dajesz im dysk, jak ich lokalne programy zadziałają to naprawiają, jak nie to do Niemiec. A jeśli “dysk” jest z macierzy to od razu leci do Niemiec, gdzie jest ekipa specjalistów. Lepiej sobie radzą z podmianą uszkodzonej elektroniki, niż z surową analizą danych.

No przecież jest wszystko opisane w raporcie z tego przypadku.

Tak dobrze im poszło, że spora część szukających spisku zasugeruje,

iż cała ta wpadka była kontrolowana od początku, do końca…

Meandry marketingu mogą być bardzo poplątane…

Czasem jeden krok w tył pozwala znaleźć lepszą ścieżkę niż obecna.

Tak czy inaczej raport wskazuje, że nie nudzili się przez ten czas.

Prawdę mówiąc niedawno czytałem artykuł przedstawiający e24cloud w nieco mniej korzystnym świetle jeśli idzie o poziom obsługi klientów: http://www.spidersweb.pl/2012/06/woblink-bedziemy-domagac-sie-wysokiej-rekompensaty-od.html

No nieźle zareklamowaliście tą firmę :D ale fakt faktem, że zrobili wrażenie :)

Oto nauczka, że jeżeli chcemy bawić się w poważne przechowywanie danych to:

1. Kupujemy macierz w wewnętrznymi UPSami pozwalającymi zrzucić dane z cache i poprawnie się zamknąć w momencie utraty zasilania.

2. Kolokacja w innym fizycznym miejscu (DRC) i tworzymy konkretne BCP.

ty se jaja robisz czy serio to napisales ?

1. to jest NORMALNA procedura budowania sprzetu serverowego

2. to jest NORMALNA procedura backupow

Jak przekuć porażkę w sukces….

Nie załapać się na helikopter, pojeździć samochodem i porównać się do NASA…

Skoro Ontrack się nie podjął, to ciekawe jak to rozwiązanie było software’owe (czyt. niestandardowe).

Odrobili lekcje… może i tak, ale czyta się to bardziej jak opowiadanie w stylu „Chcielibyśmy, żeby tak było” a prawda pozostaje w domysłach.

Cytując: PR Managera Beyond.pl, Michała Romanowskiego „(…)back-up danych jest wykonywany, ale niestety w tej awarii zniszczeniu uległy także i te dane(…)”. (żródło: http://www.spidersweb.pl/2012/06/czy-po-dzisiejszej-awarii-e24cloud-com-odzyska-dane-swoich-klientow.html).

Ale to klienci nie robili backupów i teraz będzie domyślnie włączony… To rzeczywiście „rozwiąże problem” ;p

No cóż. chmurę rozwiało, a Beyond ma jeszcze sporo lekcji do odrobienia :)

Ot marketing bullshit.

czyli co kolejny raz wychodzi na to ze jak bedziesz lamusem ale noga Ci sie nie powinie zabardzo albo uratuje Cie ktos inny to tak naprawde przekowasz to na sukces :( no polsk0!

nauki

1. olac ontrack brac mydata – jesli jestem lamerem ktory nie umie albo nie robi kopii

2. nigdy nie kupowac gotowych rozwiazan a postawic raid na byle pececie + freenas ;)

3. jesli ktos mi daje dane za pieniadze to posiadam kopie kopii i jeszcze kolejna w innym miescie.

hehe material cs jest lepszy :)

“ozpoczynamy proces poszukiwania specjalistycznej firmy ” bez komentu

11:45 – kontaktujemy się – 14:00 – podejmujemy decyzję, że do Katowic pojedziemy samochodami – czyli ten czas to nie taki wazny jednak ;) a zaoszczedzona kasa na helikopterze i potem aucie to jednak kawal kasy

ontrack – potwierdzamy ze wszyscy specjalisci zarabiaja w niemczech u nas tylko przyjmujemy skasowane zdjecia z sd

obrazamy sie na ontrack tak jak na biedronke bo pani w kasie krzywno na nas spojrzala

21 czerwca 17.00 – udzialowcy My data postanawiaja zwiekszyc ceny póki jeszcze sie da :)

aha :) kazdemu klientowy zal bylo wydac 2zl na kopie … winni sa wszyscy a ratuje nas jak to zwykle bywa pan zdzisiek za 1/10 ceny ;) cala polska jak dluga i szeroka to zna

Już sto lat temu wiadomo było, że samochodem okazało się (paradoksalnie) najszybciej :/

Nikt się na ontrack nie obraził, tylko (jeżeli jest tak jak opisane w cs) to ontrack spowodował taką sytuację.

Ciekawem czy Kroll się jakoś ustosunkuje do tych zarzutów? Konfrontacje dwóch punktów widzenia są zawsze bardzo ciekawe ;)

To nie są zarzuty tulko stwierdzenie faktu

I to jest właśnie ciekawe – często “fakty” dla drugiej strony potrafią wyglądać zupełnie inaczej ;) Choć oczywiście nie twierdzę, że tak jest w tym przypadku.

Nie mogli dopisać sobie do crona zip -r /media/sdc1/backup.zip * i zrzucać codziennie na dysior usb? ;)

Ciekawe ile ich kosztowała ta cała “impreza” i kto za to beknie.

Cennik:

Nieskomplikowane uszkodzenia logiczne (uszkodzenie MBR, bootsektora, sformatowanie partycji w systemach plików FAT/NTFS): 150zł

Żebym tyle brał to chyba bym już na porządniejsze auto nazbierał :)

Ale wielki podziw dla firmy. Wyrobić się w tyle dni z opracowaniem oprogramowania i odzyskania tych danych w tak krótkim czasie zasługuje na szacunek :)

Najlepsze w cenniku jest to, że standardowe usterki są za 100 a samo kopiowanie za 150 :)

bo za lenistwo się płaci ekstra! :)

Zastanawia mnie jedna rzecz – czy szybszym rozwiązaniem nie byłoby podjęcie próby “ściągnięcia” identycznych dwóch, nowych macierzy (a propos “poszukiwanie algorytmu stripowania”), podmiana modułu cache’a i próba wystartowania całości ? Na początku nie było co prawda wiadomo ile dysków poszło w krzaki i czy możliwe byłoby odbudowanie macierzy, ale podjęcie ryzyka może jednak warte zachodu ?

Niemniej czapki z głów dla wszystkich zaangażowanych – kawał dobrej roboty !

Z tymi samolotami to tak serio, czy zagrywka marketingowa, żeby było ciekawiej?

Ja jestem lamerem jeżeli chodzi o RAID i jedynie miałem do czynienia z LVM ze stripingiem. I zastanawiam się o co chodzi z tym odbudowywaniem RAID. Dlaczego to się musi robić i skąd tyle problemów? Przecież dane nie znikły. Dlaczego to nie mogło wstać, przelecieć fsck’iem po partycjach i tyle? Dlaczego nagle system przestał kminić gdzie jaki fragment partycji się znajduje?

Napisz na gg 4 osiem 6 30 39, mogę wyjaśnić :>

Adam, opisz tutaj, reszta też się pewnie chętnie czegoś nauczy ..

Z tego co wyczytałem w internecie, błędnie był podawanych przez systemy czas pracy UPSów. Nie wiem czy od tego jest zależne załączenie się agregatów, co by tłumaczyło chwilowy zanik zasilania. A takowy, powoduje natychmiastowe wyłączenie się dysków.

Dyski są podłączone do kontrolerów, które najczęściej używane dane trzymają w cache. W przypadku nagłego odłączenia zasilania, po prostu znikają. Również chciałbym zwrócić uwagę, na teorie przedstawione przez (prawdopodobnie Marcina z OneDedyk) – http://www.webhostingtalk.pl/topic/37717-e24cloudcom-beyond/page__view__findpost__p__318449

Więc, trzeba pamiętać, że RAID nie zabezpiecza przeciwko takim awariom. Jedyne jaką rolę pełni, to zabezpiecza przed awarią dysku(ów) (zależnie od konfiguracji, może on zabezpieczać przed awarią nawet 10 dysków – zakładając raid 10 z 20 dysków połowa z nich może ulec awarii – o ile awarii nie ulegą dyski zawierające te same dane). Nie zabezpieczy jednak przed awarią całego kontrolera i/lub wielu dysków.

Reasumując, nie dało się przelecieć fsck i system nie wiedział gdzie co jest bo:

– kontroler nie mógł ustalić kolejności zapisu danych na dysku (w sensie – który dysk jest pierwszy, drugi itd.)

– wyparowały dane z cache

Na koniec – RAID odbudowuje się gdy zostanie uszkodzony jeden (lub więcej, jak wyżej napisałem) dysk/ów aby przywrócić naturalny stan, oraz pełną redundancję.

Przykładowo, przy raid 1 z 2 dysków, w przypadku awarii jednego z nich, musisz po wstawieniu nowego dysku, przekopiować na niego zawartość nie uszkodzonego.

@Adam: niedokładnie przeczytałeś – dane z cache’a nie wyparowały, problem był właśnie w tym, aby dane z cache’a przenieść na dyski ponieważ w nim pozostały. Cache w dzisiejszych macierzach ma podtrzymanie bateryjne (kondensator) i jest dodatkowo wspomagany przez NVRAM, do którego, przy dłuższym braku zasilania (dzięki kondensatorowi), zawartość cache’a jest przenoszona i czeka tam aż do momentu ponownego włączenia.

Faktycznie, dzięki za poprawienie.

Dla zwykłego zjadacza chleba nauka z tego taka, że trzeba dokładnie poznać algorytm kontrolera zanim się on zepsuje, albo mieć kilka identycznych zapasowych.

Tak czy owak gratuluję profesjonalizmu.

Temat dosyć mi bliski. Raz padł mi RAID6 w domu (bug w migracji RAID5->RAID6 w kernelu 2.6.32 z OpenVZ). Wtedy w parę godzin skleciłem narzędzie w C do szybkiego przeszukiwania dysku pod kątem tekstu (taki odchudzony grep, blokowy – bo grep działa normalnie na liniach, i się wywala przy grepowaniu całego dysku), i odzyskałem pewne ważne pliki. Całości niestety nie udało się uratować, był tam striping po 512K, więc system plików poszedł do /dev/null. No, ale honor sysadmina zachowany, tekst najważniejszych prac udało się odczytać…

I chwała siostrze za to, że pisze w Kate lub gedit (edytory *tekstu*), a nie czymś pokroju OO.o Writera / MS Word’a :)

chyba jednak nie 100%, akcja ktorej serwer stal w chumrze zrobil sie przypadkiem windowsem.. a jeszcze nie dawno case study bylo…

http://www.jestemprzeciwacta.pl

Mistrzostwo w wykonaniu MyData, a Kroll Ontrack no cóż… nie są najlepsi. Najlepszy case-study, jaki kiedykolwiek czytałem!

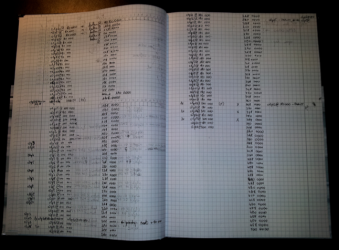

To szybko musieli pisać w tym zeszycie żeby uzyskać 12GB/min :P

W zeszycie zapisywali, jak wyczytałem schematy danych, aby poznać kolejność zapisu danych na dyskach. Ale cóż, taka natura polaczka, że jak sam nie umie, to musi się pośmiać z kogoś ;)

Adamie, kolega sobie przyżarcił, a Ty go od środkowoeuropejczyków od razu wyzywasz, więcej luzu :)

Cóż, nie zauważyłem ironii…

ps. nie uważam, że naszym chłopakom brakuje luzu :>

przy odzyskiwaniu danych czasami olowek i kartka papieru / zeszyt , to wcale nie jest glupie narzedzie – ale kto tego raz nie zaznal ten nie bedzie wiedzial o czym mowi

mi sie zdarzylo pare razy i pozwala po prostu uporzadkowac pewne rzeczy w glowie [ bo niestety wiekszosc oprogramowania nie wyswietla tabel odnosnie danych ktore sobie mozna pogrupowac ]

ja przepraszam za byc moze calkowicie bezsensowne pytanie ale… jezeli dobrze rozumiem przyczyna awarii byl zanik zasilania.. na obu liniach… a gdzie UPS lub dlaczego nie zadzialal ?

Gdzieś ktoś mówił, że zadziałał, tylko błędnie pokazywany był czas wytrzymałości baterii.

Chociaż, dziwne że agregat tego nie przejął…

Nie znam się ale fajnie się czyta, a z punktu marketingowego mistrzostwo :)

Dla mnie to “trochę” nieprofesjonalne, z tego raportu wynika, że w momencie awarii zespół e24 zaczął się zastanawiać gdzie wysłać problem.

Hmm. Grunt to przekuć marketingowo totalny fail na sukces…

Mnie uderzyły ostatnie akapity: skoro większym się stało be, to nam też mogło. Kropka. Z tym, że taki amazon czy google – faktycznie chmury, a nie wirtualizowane środowisko na jednej macierzy – nie mogą wyjąć 39 dysków (których nie chciał wziąć helikopter – wcześniej przeczytałem, że za ciężkie) i posłać do ontracka.

Jeśli dobrze zrozumiałem najtrudniejszym problemem był de facto reverse engineering kontrolera raid . Czy producenci macierzy nie udostępniają takich informacji w dokumentacji sprzętu? Nie mówię już o źródłach softu kontrolera ale chociaż o algorytmie rozmieszczania danych na dyskach.

Jeszcze jedno: autorskie narzędzie do odzyskiwania danych z raida60 nie przyda się już na nic, skoro wymieniono macierze a każdy model kontrolera może pracować w zupełnie inny sposób.

Nie najeżdżałbym też tak na Ontracka. Skoro tak poważne awarie macierzy zdarzają się w naszym kraju raczej niezbyt często, trudno oczekiwać by firma utrzymywała sztab inżynierów 24×7 czekających w pogotowiu.

Nikt nie wymaga oczekiwania 24×7.

Przeczytaj jeszcze raz case study, i zauważ że co innego ontrack mówił telefonicznie, co innego okazało się w Katowicach.

Czy tylko ja mam wrażenie, że ktoś komuś robi reklamę, antyreklamę ?

e24cloud.com zaliczył fail roku i nie zmieni tego żaden marketing, ja osobiście jak bym miał tam jakieś dane to przenosił bym je jak najszybciej w inne miejsce.

Przeczyałem z ciekawości ten artykuł. Dziwi mnie trochę narzekanie osób że firma była nie przygotowana nie wiedziała jakdziałać podczas takiej awarii.Według mnie:

1.Jeśli prowadzi się biznes, bloga, stronę hobbystyczną to robi się jej backup. W sumie dużo to nie kosztuje niecałe 2,5 zł za 1GB

2. Z tego co czytam firma podjęła wszystkie możliwości aby przetransportować dyski z Poznania do Katowic. Ciekawe która firma zastanawiał by się na wynajęciem samolotu albo helikoptera

3. Nie wiem czy firma w regulaminie ma zapis o konieczności robienia backupu czy też w przypadku utraty danych nie daje pewności za odzyskanie danych. Backup zawsze należy robić choćby nie wiem jak profesjonalna była firma i niewiadomo jaki miała sprzęt

4. Witać że zrobili wszystko żeby wyjść z sytuacji z głową

Awarie się zdarzają, czasami wszystko można mieć zdublowane po cztery razy a i tak pójdzie coś nie tak (patrz katastrofy lotnicze)

I chyba najlepsze z tego wszystkiego to to że awarię naprawili Polacy z Polskiej firmy. I to powinno być najważniejsze

2. Żadna normalna, Polska nie jest tak długa i szeroka jak Ameryka, przecież odległość między Poznaniem a Katowicami nie jest tak duża żeby lecieć awionetką.

Przeglądam właśnie dokumentację by ustalić producenta macierzy. Ciekawe wnioski, niektórych producentów można wyeliminować na starcie. Jakie macie typy? Co to było z tymi 17 dyskami w RAID-6? (gdyby to był NetApp, to zastosowaliby raid_dp, EMC VNXe ma inny striping oraz inaczej działa cache, w starszych HP inaczej działa replikacja, obstawiam Della).

Raczej nie od IBMa. IBM ma dyski od seagate’a. A to były dyski WD. Poza tym ZTCW to macierze IBM mają konfigurację zapisywaną na wszystkich dyskach. Wtedy wystarczy 1 sprawny dysk, żeby odczytać metadane o konfiguracji macierzy. Ale to tylko moje domysły.

HDS?

Mniemam, że ten 17ty dysk to spare, ino jakoś się zapałętał (no bo kto niby robi 17+16).

Dyski są z tych tańszych (sektory po 512b zamiast 520b), plus mają misalignment (offset 4k). Stąd pewnie też było ciężko odtworzyć.

Z punktu widzenia RAID 6, wygląda jak EMCowy i/lub HDSowy (się pracowało we wsiowym Cork, i to nawet nie na zmywaku), ale żeby tak z entry-level VNXe? Come on ;) Nie wierzę, że normalne firmy hostingowe tego używają.

Swoją drogą, myślę że to custom-build.

Aha, Beyond jest dużym klientem IBMa, więc prawdopodobnie mają coś z tej stajni.

Biorąc pod uwagę stan polskich dróg, oraz dostępność szybkich tras – wcale mnie to akurat nie zdziwiło ;) Myślę, że transport drogowy to większe niebezpieczeństwo uszkodzenia + dłuższy czas przewozu. I chyba nie tylko ja tak myślę…

Przeczytałem ich raport i kur**ca mnie strzeliła. Cholerny marketing i PR, faila roku próbują przerobić na swój atut. “Jesteśmy super, napisaliśmy program, walczyliśmy o dane, nie spaliśmy, nie jedliśmy, wszystko dla naszych ukochanych klientów”.

G**o prawda, nie walczyli o klientów tylko o ratowanie swojej ściśniętej ze strachu dupy!

I jeszcze te żałosne linki, że w Amazonie czy Google też się coś kiedyś sypnęło, inaczej mówiąc – “nawet nam, najlepszym się zdarza”.

Czy oferowanie usług w chmurze, kiedy tak naprawdę wszystkie macierze stoją w tej samej serwerowni nie jest na krawędzi oszustwa? Chwała mądrym ludziom, którym udało się odtworzyć dane ale taki babol po prostu nie miał prawa tam się zdarzyć.

Poza tym – gdzie oni kupili tę macierz, na stadionie? Przecież rozgryzali rzeczy, które tak naprawdę powinien udostępnić producent/support. Chyba, że to jakiś złom z piątej ręki?

nie z piatej – ze starego stadiony w wawie, zanim go zmkneli :D

chinszczyzna :P

fakt – musze im przyznac ze dali ciala, ale sie postarali i odzyskali dane, ale..

co za “geniusz” pozwolil wogole czemus takiemu funkcjonowac ????

@Radzek, pokaż nam jakieś swoje case study z awarii na tę skalę, to wreszcie ludzie się nauczą jak pisać takie rzeczy :-)

Co wyście się tak macierzy uczepili? W tzw “wielkim świecie” (nie, nie czytam gazet ;) się używa custom-buildów (Yahoo, Google, MS, … – naprawdę myślicie że Big Data* stoi na EMC czy NetAppie?).

Ci, którzy mają sporo kasy i/lub nie mają rozrośniętego działu inżynierów — faktycznie, kupują gotowce.

* – nie, nie sugeruję, że Beyond/E24 to Big Data ;) Ale pewnie aspirują, choćby działem inżynierskim.

Failem roku jest nie tylko ta macierz ale także konstrukcja serwerowni, w której mógł wystąpić pojedynczy punkt awarii zasilania – był nim jeden z wyłączników. “Jeśli coś się może zepsuć – zepsuje się na pewno”. Normalny producent macierzy wbudowuje w urządzenia mechanizmy odbudowy RAIDa nawet po poważniejszym padzie. Nie spotkałem się z przypadkiem, by NetApp FAS nie wstał po odłączeniu zasilania. Koledzy z serwisów EMC i 3PAR (obecnie HP) potwierdzają to samo. Wg mnie informacja o producencie będzie kluczowa. Ale jeden plus dla beyonda – mieli macierz FibreChannel z cache z pamięciami Flash obsługującą mirroring grup RAID, a zatem była to macierz “firmowa” a nie Ming Dziang Stor Incorporated.

Jeśli masz zasilanie z 2 torów, to jak wyobrażasz sobie zdublowanie SZR?

Skoro wiadomo które konkretnie dyski uległy awarii i pracowały one w jednej serwerownii to to nie jest chmura tylko zwykły hosting. Nie mam racji?

To w takim razie czym jest chmura i co ją różni od takie hostingu?

Ja to tak rozumiem, że chmura to hosting rozproszony. Masz np. pocztę na gmailu, ale nie wiesz na którym serwerze przechowywane są maile- czy w Stanach czy w Singapurze.

Ale nie jestem specjalistą, dobrze by było gdyby wypowiedziała się osoba bardziej kompetentna.

Ja tam nie bardzo wierzę w niektóre cyferki z tego raportu dotyczące dysków bo prawdziwe mogłyby wskazać na Producenta macierzy ;-)

Wg mnie rozsypanie się metadanych macierzy (albo nawet obu) wskazuje że nie jest to klasyczny midrange IBM DS, EMC, HDS czy NetApp.

Mnie najbardziej dziwi fakt że posypała się replika danych na drugiej macierzy.

KJ

co by nie było myData uratowała ostatnio mi moją macierz 6tkę a już żegnałem się z danymi :) teraz kupię drugą taką i będzie backup w czasie rzeczywistym na inna maszynę w zupelnie innym miejscu i mam nadzieję że przetrwam nawet trzęsienie ziemi :)