20/9/2017

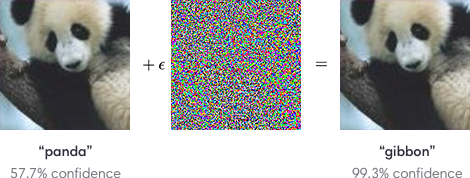

Bardzo ciekawy artykuł na temat oszukiwania systemów AI, które “rozpoznają” obiekty. Wystarczy nałożenie niezauważalnego dla ludzkiego oka filtra, aby maszyny rozpoznawały zupełnie inne obiekty od faktycznie widocznych. Tu przykład:

Złośliwe zastosowanie? Ogłupianie algorytmów wbudowanych w samochody, które zamiast znaku STOP zobaczą znak “masz pierwszeństwo” i nie zatrzymają się na skrzyżowaniu.

Weź udział z kolegami w jednym z naszych 8 cyberwykładów. Wiedzę podajemy z humorem i w przystępny dla każdego pracownika sposób. Zdalnie lub u Ciebie w firmie. Kliknij tu i zobacz opisy wykładów!

Weź udział z kolegami w jednym z naszych 8 cyberwykładów. Wiedzę podajemy z humorem i w przystępny dla każdego pracownika sposób. Zdalnie lub u Ciebie w firmie. Kliknij tu i zobacz opisy wykładów! Każdy powinien zobaczyć te krótkie szkolenia! Niektóre z nich są darmowe. Wszystkie to praktyczna wiedza i zrozumiały język. 6 topowych tematów — kliknij tutaj i zobacz szczegółowe opisy.

Każdy powinien zobaczyć te krótkie szkolenia! Niektóre z nich są darmowe. Wszystkie to praktyczna wiedza i zrozumiały język. 6 topowych tematów — kliknij tutaj i zobacz szczegółowe opisy.

Podrzucam pomysł dla rosyjskiego lub chińskiego wywiadu. Poczekać parę lat aż się autonomiczne auta upowszechnią, i zamiast atakować wzór znaku drogowego, który będzie już mocno bronionym celem, nauczyć autka że flaga USA oznacza STOP.

Wytargetowany geograficznie, solidny atak nie powodujący w zasadzie bezpośrednich ofiar w ludziach, za to blokujący infrastrukturę. Podejrzewam że karetki i służby, jako że muszą jechać ‘ofensywnie’ to nie będą miały cyfrowego kierowcy, więc ich ten atak nie sięgnie.

SZACUN!

Zgłosiłbym Cię na kandydata do pokojowej nagrody Nobla za najlepszy, największy atak, który nie zabija. I przy okazji pokazuje wyższość ludzi nad maszynami, żeby co niektórzy, np. w eurokołchozie, nie chcieli zmuszać do przejścia na wyłącznie autonomiczne auta.

Pisaliśmy również o tym zagadnieniu w kontekście WAF i ML/AI https://blog.greywizard.com/2017/02/uczenie-maszynowe-w-srodowisku.html